近年來,大模型的迅速發展賦能了大量交互式的智能代理(大模型 Agent),使後者在類似代碼生成、自動駕駛、個人助理等領域展現出令人矚目的潛力。

這些 Agent 通常需要類似人類的記憶能力,以便持續學習並逐漸提升自身表現。具體而言,Agent 需要記錄並回憶曾經遇到的任務輸入以及對應的輸出結果,從而幫助其在新的任務中取得良好表現。

然而,目前各種 Agent 所使用的記憶模塊往往是爲特定任務專門設計的。例如,自動駕駛 Agent 存儲的是車輛的軌跡與狀態數據,代碼生成 Agent 保存的是代碼片段,而個人助理型 Agent 則可能傾向於總結對話信息。這種碎片化的、任務導向的設計方式,使得研究記憶管理的通用規律與共性變得極其困難。因此,美國伊利諾伊大學香檳分校本科校友、美國哈佛大學博士生熊梓迪和所在團隊決定迴歸到最基本的記憶管理操作——添加操作與刪除操作,以便解決這樣一個通用而核心的問題:到底該如何管理記憶,才能長期提升大模型 Agent 的表現?

圖 | 熊梓迪(來源:熊梓迪)

研究團隊的目標是提供系統性的實驗證據和具有普適性的原則,避免開發者因爲缺乏通用準則而只能憑經驗制定策略,從而導致性能的不穩定甚至退化。

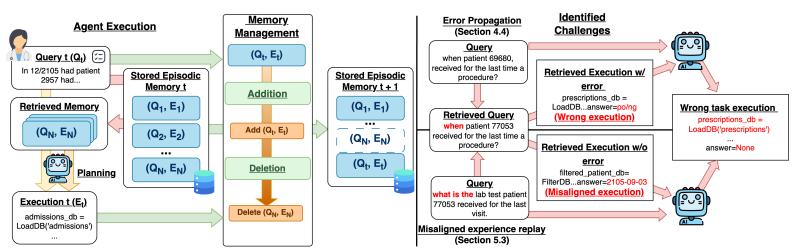

如前所述,與以往關注複雜記憶機制設計的研究不同,研究團隊的研究重點回歸到記憶管理最基礎的兩個操作上:

- 添加:判斷一個新任務的執行結果是否值得被記憶。

- 刪除:決定何時以及按照什麼標準刪除過去的記憶。

通過研究不同精度的外部反饋作爲這兩項操作的執行標準,研究團隊發現了以下三個核心規律:

- 第一個規律是經驗跟隨現象(Experience-Following):Agent 在處理當前任務時,傾向於複製檢索到的相似歷史任務的輸出,而這種現象不區分記憶質量的好壞,具有高度一致性。

- 第二個規律是錯誤傳播效應(Error Propagation):當記憶添加的外部反饋精度和評估標準不嚴,錯誤或低質量的任務執行結果被存入記憶後,會不斷被後續任務所模仿,從而導致一連串的決策失誤,甚至使 Agent 長期表現退化。

- 第三個規律是經驗回放失配(Misaligned Memory Replay):即使某些記憶本身正確,但如果它們與當前任務的上下文不匹配或已過時,仍然會拖累 Agent 的表現。因此,需要通過精準的外部反饋進行持續維護或刪除。

整體而言,研究團隊揭示了一個長期被忽視的重要問題,即精準可靠的外部反饋對於記憶管理設計的重要性。在絕大多數實際場景中,由於缺乏這種高質量反饋,Agent 的記憶系統反而可能阻礙而非促進其長期的表現。

研究團隊希望本研究能夠激發更多關於大模型 Agent 各模塊通用機制的系統性研究,並期待本工作中的發現能夠爲未來記憶模塊的設計提供實證參考,從而推動構建更智能、具備自我演化能力的大模型 Agent。

(來源:https://arxiv.org/pdf/2505.16067)

談及研究過程,熊梓迪對 DeepTech 表示,他與本次相關論文的共同通訊作者 Zhen Xiang 師兄(現爲美國佐治亞大學助理教授)希望找到一種普遍適用於各種 Agent 的記憶管理方案。研究早期,他們嘗試了許多複雜的方法,但發現由於 Agent 任務差異巨大,很難提煉出真正通用的解決方案,也難以清晰界定研究問題。

反思之後,研究團隊決定迴歸最基礎的記憶操作,聚焦於記憶的添加和刪除。之所以選擇這兩個操作,是因爲它們不僅是記憶系統中最基本的部分,同時在不同 Agent 中都有明確可能的實現方式。

研究團隊隨後建立了一個統一的實驗框架,選擇了具有代表性的多個不同領域的 Agent,包括醫療數據、自動駕駛、物聯網安全等,以充分驗證普適性。經過大量的實驗和分析,研究團隊發現了 Agent 記憶管理中三個重要的共性問題:經驗跟隨、錯誤傳播和經驗回放失配。這些發現幫助研究團隊明確了準確可靠的外部反饋在記憶管理中不可或缺的角色,也爲後續的研究和應用提供了明確的方向。

不過,熊梓迪坦言:“實驗中應用程序編程接口(API,Application Programming Interface)的花銷非常昂貴,比如像 GPT-4o 作爲 backbone 讓 Agent 在幾千條任務上跑的花銷真的很驚人。”這也更加凸顯了本次研究的不易。

日前,相關論文以《內存管理如何影響大模型代理:經驗跟隨行爲的實證研究》(How Memory Management Impacts LLM Agents: An Empirical Study of Experience-Following Behavior)爲題發在 arXiv[1],熊梓迪是第一作者。

圖 | 相關論文(來源:https://arxiv.org/pdf/2505.16067)

未來,研究團隊希望進一步探索如何在缺乏高質量外部反饋的情況下,儘可能減少記憶模塊可能帶來的負面影響,並提升其長期表現。他們相信,這對於現實的大模型 Agent 應用具有重要的價值。

參考資料:

1.https://arxiv.org/pdf/2505.16067

排版:劉雅坤