2026 年 2 月 12 日,普林斯頓大學機械與航空航天工程系副教授 Anirudha Majumdar 在 X 上發表了一篇長博文,直面一個正在機器人學界升溫的核心爭論:爲具身智能構建世界模型,到底應不應該去“預測像素”?

Majumdar 是普林斯頓機器人研究倡議(Princeton Robotics Initiative)的聯合主任,同時在 Google DeepMind 擔任兼職訪問研究科學家。他的研究聚焦於讓機器人在以人爲中心的環境中安全、可靠地泛化到新場景,曾獲斯隆研究獎(Sloan Fellowship)、兩次 Google 教授研究獎,以及《國際機器人研究期刊》(IJRR)年度最佳論文等榮譽。

圖丨Anirudha Majumdar(來源:Princeton MAE)

他本人也是去年 12 月 Google DeepMind 那篇引發廣泛關注的 Veo 機器人策略評估工作的合作者之一,該研究展示瞭如何用前沿視頻生成模型 Veo 作爲機器人策略的“世界仿真器”,通過 1,600 多次真實世界評估驗證了其有效性。

在文章中,Majumdar 表示當前機器人領域的世界模型幾乎等同於視頻生成模型,這條路線在概念簡潔性、評估便利性、商業推動力等方面擁有不容低估的短期優勢;但 Yann LeCun 倡導多年的潛在世界模型(以 JEPA 架構爲代表)在長時域規劃上更具前景,可能在五年左右的時間尺度上成爲關鍵組件。兩者並非你死我活的替代關係,更可能走向協同。

以下是這篇博文的全文編譯。

機器人的世界模型

在機器人學界,一個大致的共識似乎正瀰漫在空氣中:未來的通用策略將建立在“世界建模”的配方之上,而非迄今爲止占主導地位的 VLM(Vision-Language Model,視覺語言模型)骨架方案。

論點如下:VLM 沒有被顯式地訓練來預測未來,因此在幾何、空間和物理推理能力上,也就是預測動作精細後果所需的那類能力並不可靠。相比之下,世界模型允許機器人“想象”未來以進行規劃,例如:(1)生成一段想象中成功執行的視頻,再用逆動力學模型推斷所需動作;或者(2)直接使用一個以動作爲條件的世界模型來優化規劃。

2026 年初的機器人學:世界模型=視頻模型

在 2026 年初,機器人領域的世界建模由視頻世界模型主導,即那些被訓練來預測未來視頻幀(以文本以及潛在的動作爲條件)的生成式模型。這些模型建立在視頻建模領域巨大進步的基礎之上:在互聯網規模數據上訓練的基於擴散的架構,能夠生成驚人逼真的視頻,包含複雜的物理交互,例如來自 Veo、Cosmos 和 Wan 的視頻。

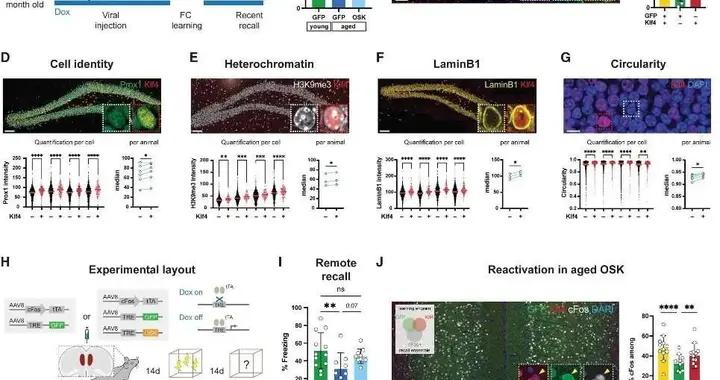

僅在過去一年中,我們就已經看到經過機器人數據微調的視頻模型能夠執行策略評估、數據生成和推理時規劃生成;相關綜述可參閱文獻[1]。就我個人而言,參與 Veo 的策略評估工作提供了一次巨大的認知更新,看到如下所示的視頻模型“仿真”,讓我確信視頻模型終於到了可以在機器人領域大展身手的時刻。

視頻模型的挑戰

儘管結果令人振奮,當前所有用於機器人的視頻模型都受到同一組幻覺問題的困擾:物體憑空複製、無中生有、憑空消失,或者在自發地或在被遮擋後重新出現時發生形變。

此外,長時域生成是一個重大挑戰:當前機器人領域的視頻模型很難在超過 20-30 秒之後仍能產出高質量的生成結果。

潛在世界模型:不要預測像素

從直覺上看,視頻建模對於世界模型而言似乎是一個不必要地困難的任務。預測背景中樹葉運動的像素級細節,或者預測即將出現在我辦公室門口的人的精確面部特徵,顯然是沒有必要的。

我們可以轉而構建一個潛在世界模型(latent world model),只預測環境的某些特徵。具體來說,通過預測可預測之物,我們可以將表徵能力集中在真正重要的事情上,而不是那些細枝末節,比如在特定光照條件下物體的精確外觀。

Yann LeCun 多年來已經非常有力地闡述了這一論點(參見他在普林斯頓機器人研討會上的演講)。他在 Meta 和 NYU 的團隊開發了多種形式的 JEPA(Joint-Embedding Predictive Architecture,聯合嵌入預測架構),這種架構學習觀測的潛在表徵,以預測其他(例如未來)觀測的表徵。

V-JEPA 2 展示了這種自監督學習如何湧現出有用的視頻特徵。此外,該工作還展示了模型的動作條件版本如何通過在推理時優化動作序列來實現機器人規劃。

潛在世界模型的論點在長時域任務上尤其有說服力。預測世界在未來 10-20 秒內如何在像素層面演化似乎還說得過去,但將這一尺度擴展到分鐘或小時級別,既極其困難,又完全沒有必要。

爲什麼視頻模型將在短期內勝出

在接觸視頻模型之前,我曾被上述潛在世界模型的論點所說服;只預測世界顯著特徵的極簡主義方法確實很有吸引力。然而,我想要論證的是,視頻建模在技術和實踐上有一些不應被低估的顯著優勢。這些優勢在一年前對我來說並不顯而易見,我希望在這裏把它們明確寫出來能對其他人有所幫助。

概念上的簡潔性。視頻建模的任務是明確無歧義的:預測未來幀。類似於 LLM(Large Language Model,大語言模型)的下一個 token 預測,一個清晰的監督信號可以爲下游任務帶來良好的特徵,以及諸如物體分割、視頻編輯和視覺推理等湧現能力。

這與 JEPA 形成鮮明對比:預測可預測之物這一任務並非完全指定的(not fully specified),如果實現不當會導致表徵坍縮——構建一個可預測嵌入的最簡單方式就是讓它成爲常數。

清晰的評估指標。對視頻模型進行爬坡優化(hill-climbing)是直截了當的。有標準指標(如 LPIPS 或 FID)可以用來評估視頻生成的質量。JEPA 則不然,它優化的損失函數並不一定與下游性能相關(不過最近的 LeJepa 論文在這方面展現了一些積極跡象)。

推理時縮放與驗證器。視頻模型允許 VLM 被直接用作驗證器。通過生成多段視頻並用 VLM 打分,我們可以過濾掉不真實或低質量的生成結果。這提供了一個簡潔的推理時縮放配方。

視頻模型賦能策略評估。視頻模型可以充當機器人策略的完整仿真器。爲了執行閉環 rollout,仿真器的輸出必須與策略的輸入匹配。對於視覺運動控制(visuomotor control),這就要求生成完整的圖像(除非策略被迫在潛在世界模型的潛在空間中接收輸入)。

視頻模型與圖像編輯器的天然組合。視頻模型可以接受編輯後的幀作爲輸入。正如我們在 Veo 工作中所展示的,這提供了一個簡潔的配方,用於在分佈外(out-of-distribution)場景中進行策略評估。

真實世界的觀測可以被編輯(例如引入新物體或背景),然後用於條件化策略 rollout。可以想象,類似的策略也能用於視頻模型在分佈外場景中的數據生成(類似於 DreamGen)。

巨大的商業激勵。支持視頻模型的主要論點實際上是一個非技術性的。開發好的視頻生成模型面臨着巨大的商業壓力。從社交媒體應用到電影製作,視頻模型將以獨立於機器人領域的速度快速發展。

我們已經反覆看到這部電影的劇情,從用於遊戲的深度相機,到用於智能手機的 IMU(Inertial Measurement Unit,慣性測量單元),再到用於 NLP(Natural Language Processing,自然語言處理)的 LLM——因獨立商業原因開發的技術,最終革新了機器人學。同樣的事情很可能也會發生在視頻模型身上。

在近期(2-3 年),我預計視頻模型將繼續作爲機器人世界建模的主導力量。尤其是對於短時域操作任務,這仍然是當今機器人學大部分研究的北極星,我預計上述優勢將超過潛在世界模型的潛在收益。

JEPA 會在長期勝出嗎?

JEPA 用於機器人的核心未解技術問題是:JEPA 學到的"可預測特徵"是否等同於對機器人有用的特徵?可預測的特徵本身並不一定有用——我們總是可以預測那個將任何圖像映射爲常數的特徵。然而,DINO 的存在提供了一個強有力的證據,它可以說是 JEPA 風格自監督學習最大的成功案例。

DINO 特徵在廣泛的下游視覺任務中取得了最先進的結果,如分割、深度預測和物體檢測。類似的收益能否在機器人世界建模中實現,仍然是一個開放問題。

爲了超越視頻模型,JEPA 還需要克服我上面強調的一些商業壓力。然而,LeCun 的 AMI 初創公司似乎有可能積聚足夠的資源來跨越這一障礙,並展示 JEPA 在世界建模方面的威力。

如果讓我在大約 5 年的時間線上下注,我會押注 JEPA 成爲機器人世界模型的關鍵組成部分。我懷疑,一旦我們在基礎操作技能上取得進展,超過幾秒的時間跨度將真正開始在機器人學中變得重要,屆時 JEPA 在規劃方面的優勢應該會顯現出來。

然而,基於上一節強調的原因,我不認爲 JEPA 會一對一地替代視頻模型。首先,JEPA 和視頻模型可以協同工作。事實上,我們已經看到了將兩者結合的工作,例如用潛在世界模型在推理時改進視頻模型。此外,JEPA 的表徵學習目標也可以與視頻重建目標同時應用。最後,對於策略評估等用例,視頻生成有非常明確的優勢(例如使用圖像編輯來生成場景變體)。

無論事情最終如何發展,這都是一個非常激動人心的時刻,不同的實體正在下注不同的路線,還有一些根本性的開放問題等待解決。

參考資料:

1.https://x.com/Majumdar_Ani/status/2021242532517040560

2.Mei et al., 2026, "Video Generation Models in Robotics -- Applications, Research Challenges, Future Directions".

運營/排版:何晨龍