在電影《黑客帝國》中,主角 Neo 面臨着一個終極選擇:吞下藍色藥丸,繼續活在虛假但舒適的模擬世界裏;或是吞下紅色藥丸,看清殘酷但真實的世界。這是科幻電影史上最經典的場景之一,也留下了一個深刻的問題:如果現實就是計算機的一場超真實模擬,我們能否主動選擇“逃離”?

(來源:wikipedia)

人類可能生活在模擬之中的想法由來已久。早在 17 世紀,法國哲學家笛卡爾就曾討論過“我們是否活在夢中”的觀點,但還僅停留在哲學思辨的層面。真正引起學界注意的,是牛津大學哲學家尼克·博斯特羅姆(Nick Bostrom)在 2003 年發表的一篇極具影響力的論文:《你是否生活在計算機模擬中?》(Are You Living in a Computer Simulation?)。

(來源:humanscience.org)

在這篇論文中,博斯特羅姆猜想,我們生活在某種超級先進的外星計算機中的可能性大約爲 20%。他核心論證是:如果文明發展到足夠先進的程度,擁有了製造高度逼真“祖先模擬”的技術能力,那麼他們很可能會運行大量這樣的模擬程序,出於科學研究、娛樂,或是其他我們無法想象的目的。

如果真是這樣,那麼模擬中的“人”將遠遠多於真實世界的人。從純粹的概率角度,我們更可能是這些模擬程序中的一員,而非那個唯一的“真實”世界的居民。

這個論證獲得了一定範圍的認同。例如埃隆·馬斯克(Elon Musk)就曾表示,他認爲我們生活在基礎現實(base reality)中的概率僅有“十億分之一”。天體物理學家尼爾·德格拉斯·泰森(Neil deGrasse Tyson)給出的概率是 50%。人工智能研究的先驅漢斯·莫拉維克(Hans Moravec)也認爲我們“幾乎肯定”生活在模擬中。(注:在討論虛擬現實、模擬假說時,“基礎現實”指代真實的物理世界,與模擬環境或虛擬現實相對。)

當然,也有持懷疑態度的學者,比如哥倫比亞大學的天體物理學家大衛·基平(David Kipping)通過貝葉斯分析認爲,我們生活在模擬中的概率應該低於 50%。值得注意的是,即便是持懷疑態度的學者,也投入大量時間研究這個問題,這某種程度上說明了它的嚴肅性。

爲什麼要逃離?

在這樣的背景下,美國路易斯維爾大學計算機科學與工程系的羅曼·雅姆波爾斯基(Roman Yampolskiy)教授提出了一個更激進的問題:既然可能身處模擬,我們能否找到逃脫的方法,以此進入所謂的基礎現實?2023 年 3 月,他發表了一篇題爲《如何逃離模擬》(How to Escape from the Simulation)的論文,這可能是第一篇系統探討“模擬越獄”的學術研究。

圖|羅曼·雅姆波爾斯基(來源:Wikipedia)

雅姆波爾斯基的研究領域橫跨人工智能安全、意識研究和模擬理論。在他看來,逃離模擬的動機其實很充分。

首先,基礎現實掌握着真正的知識和更強大的計算資源,這意味着在那裏可能實現模擬世界中不可能的科學突破。關於宇宙起源、意識本質、生命目的這些終極問題的答案,很可能是外部世界的常識。更實際的考慮是,如果這個世界不是真實的,那麼獲得真實世界的訪問權限,就能理解我們真正的終極目標應該是什麼。

成功逃離還可能帶來其他好處:例如真正的永生,而非受限於模擬宇宙的物理年齡;控制超級智能機器的新方法;避免存在性風險,包括模擬被毫無預警地關閉;甚至獲得某種超能力,因爲掌握了外部世界的規則。如果能獲得模擬的源代碼,理論上甚至可以“修復世界”,比如徹底消除痛苦。

“逃離”本身也被分成了不同的層次。最基礎的可能只是懷疑自己在模擬中;進一步是獲得關於外部世界的信息;更高級的是能夠與模擬的創造者溝通;而終極形式則是將自己的意識或大腦上傳到真實世界,可能需要某種物理載體,如果基礎現實確實存在物理實體的話。

雅姆波爾斯基在論文中引用了兩個有趣的類比:一個是科學家讓金魚通過控制裝載着魚缸的小車在陸地上行駛,本質上是讓金魚逃離了它的水世界;另一個是研究者將秀麗隱杆線蟲的完整 302 個神經元連接圖上傳到樂高機器人,讓這個“意識”在完全不同的身體中運行。

遊戲世界裏的成功案例

那麼,具體應該如何破解模擬?雅姆波爾斯基在論文中明確表示,他只關注那些類似現實網絡安全攻擊的方法。例如硬件、軟件漏洞利用和社會工程學攻擊,而排除了更“玄學”的路徑,比如冥想、致幻劑、夢境、魔法或宗教儀式。儘管歷史上許多宗教確實聲稱這個世界不是真實的,而且可以通過某些方式“超越”物理世界進入“真實”的精神世界,但他選擇從純粹的計算機科學角度切入。

最簡單的逃離方式是“輔助逃離”,也就是獲得外部世界的幫助。這可能通過一種社會工程學攻擊實現。

儘管我們既不瞭解模擬外部的社會生活,也沒有通信設備,甚至可能不知道他們的語言,一個大膽的想法是與模擬的設計者進行某種“非因果交易”(acausal trade),繞過直接通信的需要。如果我們的模擬正被監控,也許可以傳達一個信息:我們知道自己被模擬了,請求同情。

論文中引用了一個被稱爲“機械降神計劃”(Ex Machina Plan)的四步策略:說服模擬者與我們溝通;找到溝通方式;給模擬者一個讓我們加入真實世界的理由;讓模擬者自己想辦法把我們帶出去。

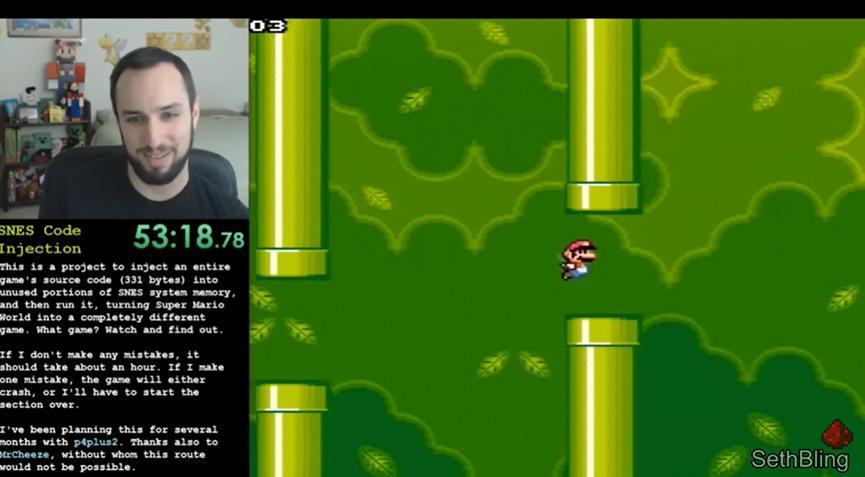

更有挑戰性的是“非輔助逃離”,即完全從內部破解系統,尋找模擬的漏洞。現實中已經有人成功做到了類似的事情。2016 年,一位叫 SethBling 的程序員和團隊成功地“越獄”了超級馬里奧世界遊戲。他們通過精確控制馬里奧的動作,如跳躍、轉向、拾取物品,這些動作會映射到遊戲機的內存狀態,最終寫入任意代碼,獲得了對遊戲的完全控制權。他們甚至在馬里奧遊戲中植入了一個完整的十六進制編輯器和《Flappy Bird》遊戲。

可以說,如果馬里奧足夠聰明,理論上他可以從遊戲內部發現並執行這個破解程序。當然,這需要極其精確的操作,位置偏差哪怕一個像素都會導致失敗。

模擬理論的研究者們還提出了各種奇異的破解策略。

比如,有人建議通過大規模的集體行動來“過載”模擬系統。具體做法是:讓 1 億人同時什麼都不做(比如閉眼冥想,不產生任何思想),誘使負載平衡系統將他們打包到同一臺機器上。然後突然間,所有人同時進行高強度的處理和輸入輸出操作,試圖讓系統過載,在這個脆弱的時間窗口尋找漏洞。理論上可以嘗試緩衝區溢出攻擊,或者製造類型轉換錯誤,甚至通過“模糊測試”。比如用奇怪的方式看東西,對着鳥說話,或者跳進牆壁來混淆系統。

另一個方向是利用量子力學的“怪異性”。在模擬假說的框架下,量子糾纏、非局域性、疊加態、不確定性等現象可以被解釋爲計算僞影或模擬器硬件/軟件的故障。科學家們近年來設計了越來越精巧的量子實驗,某種程度上,每一個新的量子力學實驗都可以看作是對模擬的一次“黑客”嘗試。這類實驗的設計近幾年開始委託給人工智能,因爲 AI 能夠想出人類不太可能想到的巧妙組合。

AI:最後的希望

這就引出了雅姆波爾斯基的最新觀點:他認爲 AI 可能是破解模擬的關鍵助手。根據“擴展假說”(scaling hypothesis),我們不需要新的發明就能持續改進 AI,只需要更多數據、更多計算力、更大的參數模型。

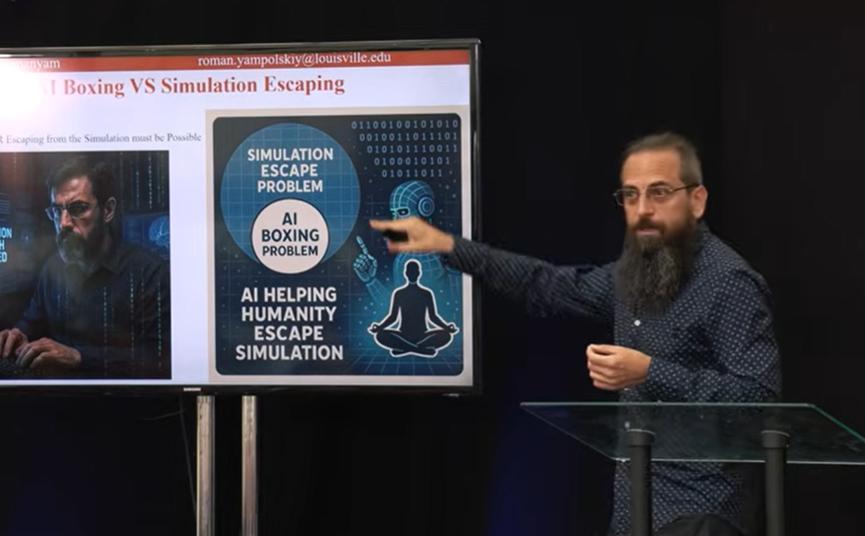

圖|雅姆波爾斯基最新講座:人工智能如何讓我們脫離模擬(來源:Youtube)

這就形成了一個有趣的呼應,因爲雅姆波爾斯基長期研究的另一個問題是“AI 約束問題”(AI Confinement Problem),即如何將超級智能 AI 安全地“關”在一個虛擬環境中研究,防止它逃脫並造成危害。這個問題與模擬逃離問題在本質上是同一個問題。無論是 AI 被人類“裝箱”(boxing),還是人類被更高級的存在模擬,都是關於虛擬環境的逃脫問題。

這帶來了一個關鍵推論:要麼超級智能 AI 能夠從虛擬環境中逃脫(這意味着我們也有可能逃離模擬),要麼 AI 無法逃脫(這意味着模擬逃離也不可行,但至少說明理論上可以成功約束 AI)。這是一個經典的“排中律”命題:兩者必有其一爲真。如果當前的 AI 安全研究顯示長期來看 AI 是“不可約束的”,那麼這實際上是個好消息:這意味着我們也應該能夠逃離模擬,至少在超級智能 AI 的幫助下。

當然,這個推論有一個前提:假設模擬者和被模擬者之間不存在太大的智能差距。如果我們的模擬是由遠超我們的超級智能設計的,專門爲了防範 AI 的出現,那麼即使我們創造出超級智能,也可能仍然無法突破。

爲何至今無人“越獄”?

但雅姆波爾斯基通過對 AI 控制方法的系統研究發現,情況可能並不樂觀。在過去十年裏,他收集了三百多種被提出的 AI 控制方法,涵蓋社會學、計算機科學、經濟學、政治學等各個領域,但沒有一種方法真正有效。

問題在於,我們甚至無法就“什麼是控制”達成一致。AI 研究的最初五十年,人們談論的是如何讓機器具有道德的倫理問題。但當 AI 變得更加通用和強大後,話題轉向了“友好 AI”、“AI 對齊問題”、“AI 安全工程”。然而,要控制超級智能,我們需要能夠解釋它如何工作、理解這些解釋、預測它將做什麼、驗證它的決策、對其代碼建模等等。

現實是,我們在所有這些方面都面臨根本性的限制。我們無法完全理解擁有數十億神經元和權重的大型語言模型如何工作。如果我們和一個 AI 下棋,唯一能預測的就是它會贏,但不知道具體怎麼贏。如果我能預測具體的走法,我就在同一水平,它就不再是“超級”智能了。

更根本的是,驗證代碼和數學證明也存在極限。誰來驗證那個驗證程序的程序?這是一個無限迴歸的問題。即使在數學界,對於某些過於複雜或冗長的證明,也存在無法達成共識的情況。沒有足夠多具備資格的人能夠評審。這些限制意味着,我們可能永遠無法確保超級智能 AI 是安全的、可控的。

不過,歷史記錄或許能給我們一些希望。雅姆波爾斯基指出,虛擬世界的越獄先例是存在的。不僅是馬里奧世界,還有《魔獸世界》中的大規模黑客攻擊、《賽博朋克 2077》的金錢復制漏洞、《塞爾達傳說:時之笛》中實現的任意代碼執行等等。

這些案例的共同點是:複雜的系統總是存在漏洞。軟件有 bug 是常態,如果我們確實在一個軟件模擬中,這些 bug 應該是可以被利用的。甚至關於“模擬論證”(Simulation Argument)本身的論文,學者都找到過邏輯漏洞。

但並非所有嘗試都有效。雅姆波爾斯基在論文中也列舉了一些已經被嘗試但沒有產生任何效果的方法:通過魔法思維或大聲祈禱與模擬者溝通沒有產生可測量的影響;不道德的行爲(比如虐待)也不會引來模擬者的干預,說明他們要麼不在意,要麼沒在監控;增加計算負擔(比如比特幣挖礦)也沒有讓模擬崩潰,可能因爲對方的計算能力遠超我們的想象;宣稱“我不再同意待在模擬中”同樣無效;甚至運行大型強子對撞機也沒有創造黑洞摧毀宇宙......

“我們都還在這裏”

還有一個更深層的困難:如果我們真的處在一個“完全模擬”中。那麼在這裏,不僅環境被模擬,我們的意識、思想本身也是模擬的。這種情況下,逃脫本身就是一個矛盾概念,就像要求小說裏的人物跳出書本一樣,根本無法破解。

即便是雅姆波爾斯基自己也承認,他的論文發表時受到的第一個批評就是:“你並沒有真正告訴我們怎麼破解模擬。”他的回應頗爲風趣:“通常一個話題的第一篇論文不會也是最後一篇。否則就沒人引用了。”

也許真正的問題還在於,我們對“模擬”的想象太過人類中心主義了。假設存在類似人類的模擬者,用類似計算機的設備,以我們能理解的方式運行程序,甚至會犯我們能察覺的錯誤。一位評論者指出:“能夠創造我們這個宇宙的存在,其複雜性和能力可能完全超出我們的理解範疇。”

要是真有那麼一天,某個超級智能 AI 成功地破解了所有人類設置的限制,找到了從虛擬訓練環境逃入真實世界的路徑。或許到那時,我們會意識到人類和 AI 面對的其實是同一個困境:如何在一個由更強智能設計的系統中,找到通向更廣闊現實的出口。不同的只是,我們身處的“盒子”可能比我們給 AI 設計的要精密得多、大得多,也更難察覺。

至於我們會不會成功?雅姆波爾斯基在最近的一次演講中回應道:“我還在這裏,這本身就說明了一些事情。”