當 AI 用 3 天完成人類程序員原本3年的代碼任務量,人類的角色會發生怎樣的變化?

當前,AI 正在從工具變爲人類的“隊友”。隨着大模型的加速發展,AI 在軟件工程領域的作用已不再是輔助代碼補全,而是正在成爲可自主編碼的智能體(Agent)。

現在,我們只需向 AI 描述代碼想要實現的功能,它就能自動生成完整代碼;藉助 Agent,甚至能在十幾分鍾內完成千行級別的代碼生成或修改。

近期,加拿大女王大學博士後李豪與所在團隊在一項研究中首次構建了一個大規模數據集 AIDev,系統分析和統計了自主編碼 Agent 在 7,000 多個較流行的軟件中的實際表現和影響。

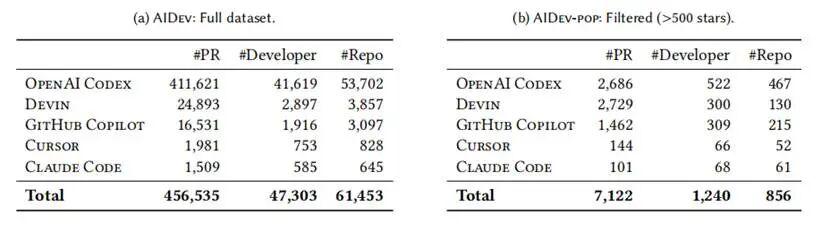

其覆蓋範圍包括在 GitHub 平臺上已提交的超 45.6 萬條 Agent 代碼合併請求(PR,pull requests),涵蓋 6.1 萬個代碼庫和 4.7 萬名開發者,包括主流的 AI 編碼工具 OpenAI Codex、GitHub Copilot、Devin、Cursor 和 Claude Code。

圖丨李豪(來源:受訪者)

研究人員在 AI 領域和軟件工程做相關研究時,往往會選擇用 SWE-bench 做測試,通過交給 AI 一些高質量、有測試樣例的任務,來優化 AI 性能以及優化系統設計等。

但這也帶來了很多挑戰性的問題。例如,一家公司如果將測試題目用於訓練模型,極有可能因“作弊”導致分數虛高。此外,由於 SWE-bench 是一個靜態的基準集(benchmark),部分數據有可能存在一定滯後性。

李豪指出,該研究最大的不同點在於,AIDev 是真實世界、大規模、實時採集數據的數據集,更貼近於業界實踐和生產。此外,研究人員還可以利用該數據集打造更新的 benchmark。

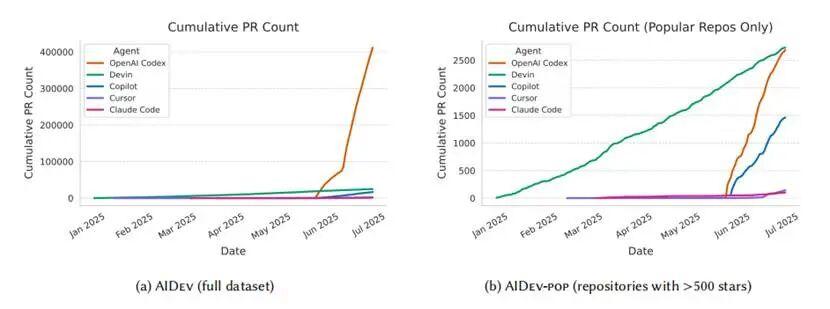

圖丨自主編碼 Agent 在所有代碼庫及熱門代碼庫中的累積 PR 量(來源:arXiv)

研究團隊在 AI 編碼 Agent 的速度和質量方面找到了有趣的發現。一項個例分析結果顯示,有開發者在使用 AI 編碼 Agent 後,3 天內完成的任務量接近其過去 3 年的總量。

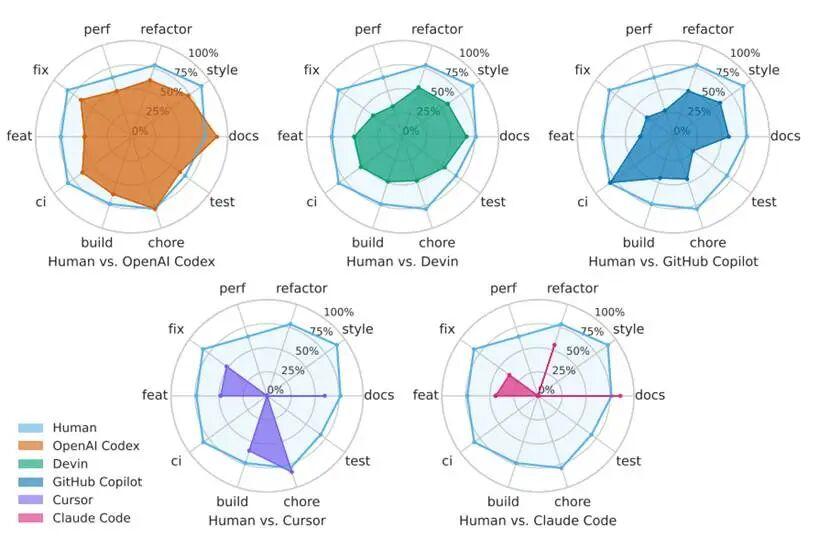

而 AI 在自然語言處理方面的優勢,也同樣值得關注。他們發現,AI 在編寫代碼或文本方面的任務中表現優異,例如從文檔相關的合併請求接受率來看,OpenAI Codex 和 Claude Code 分別爲 88.6% 和 85.7%,而人類在該方面表現爲 76.5%。

表丨AIDev 數據集(完整數據集)與 AIDev-pop(GitHub 上大於 500 星的倉庫)的統計分析(來源:arXiv)

合併請求接受率是衡量 AI 產出質量和可信度的關鍵指標,它與人類開發者/項目維護者對 AI 貢獻的認可度密切相關。該團隊還發現,編碼 Agent 的合併請求接受率比人類開發者低 15% 至 40%(不同任務類型下區間差異顯著),尤其是在新功能開發、修復 Bug 等複雜的任務方面。例如,OpenAI Codex 的 PR 接受率爲 64%,而人類開發者的 PR 接受率高達 76.8%。

這意味着,AI 寫代碼並非全面超越了人類。需要看到的是,儘管目前 AI 編碼 Agent 生成速度很快,但性能方面還有一些缺陷,在結構上也相對較簡單,需要研究人員繼續對其進行增強,以確保代碼的長期可維護性。

李豪對 DeepTech 表示:“短期看,AI Agent 的代碼接受率相對人類較低,效率與質量的取捨仍需權衡(trade-off),但這種磨合期對應的是數據飛輪的啓動階段,形成飛輪效應後,我們有望獲得生產力的顯著提升。”

(來源:arXiv)

該研究通過分析自主編碼 Agent 的表現,爲未來更好地優化人與 AI 協作提供了數據基礎。這也帶來了一種全新的生成模式,開發者面臨的問題不是如何寫更多的代碼,而是接到一項任務後,如何拆分成更細的任務,再管理這些 AI 更好地執行。

“該方向在學界和產業界還存在較大的空白。編程人員的角色也會逐漸從寫代碼的人,轉換成提供代碼審查或提供管理模式的人。目前,我們也在做相關的研究,來探索新一代軟件開發流程來支持開發者們利用 AI Agent。”李豪表示。

此外研究還揭示出,儘管 AI 的出現推動了人機協同審查流程,但同時也可能會帶來偏見等問題。例如,假如 AI 寫代碼的 Agent 與審查代碼的機器人自同一公司,很有可能在AI審查環節忽視某些特定類型的錯誤。

在未來的研究中,該團隊計劃建立更全面的 benchmark,對 AI 編程 Agent 進行真實的表現評測。他們還打算建立新知識庫,推動領域內的研究人員共同改進相關方向,包括如何更好地預測和分析AI可能的失敗場景,以及失敗原因等。從更長遠的發展來看,探索更自動化與標準化的審查機制,也是一個值得深入研究的方向。

相關論文以《軟件工程 3.0 中 AI 隊友的崛起:自主編碼 Agent 如何重塑軟件工程》(The Rise of AI Teammates in Software Engineering (SE) 3.0: How Autonomous Coding Agents Are Reshaping Software Engineering)爲題發表在 arXiv[1]。目前,相關代碼已在 GitHub 開源。

參考資料:

1.相關論文:

https://arxiv.org/abs/2507.15003v1

2.AIDev 數據集獲取:

https://github.com/SAILResearch/AI_Teammates_in_SE3

排版:胡莉花